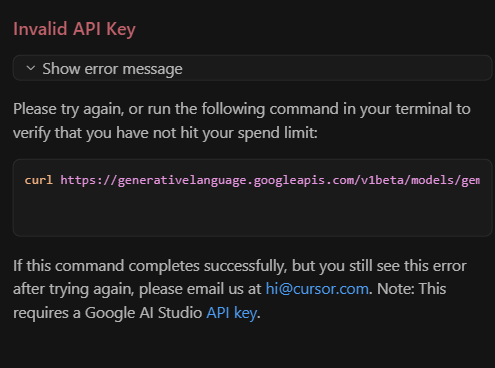

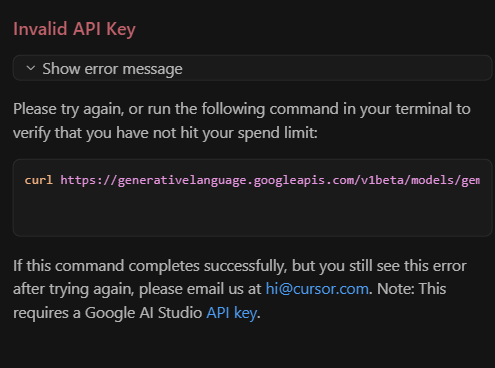

先日、Cursor上でGoogleの次世代LLM「Gemini」を使おうとした。PaLM APIのエンドポイントにリクエストを投げてみたところ、JSONの構造が違うだの、モデル名が不明だの、そもそもキーが無効だのとエラーが次々に返ってきた。公式ドキュメントの例に従って、generateMessage や generateText のエンドポイントを指定してみたが、それでも「Invalid JSON payload」や「Model not found」のようなメッセージを吐かれてしまった。

まずは自分のGoogle Cloudプロジェクトで課金やAPIの有効化を再確認した。APIキーも作り直し、アクセスポリシーを確認した。念のため余計な文字や改行を含まないようにキーを貼り付けてみたが、症状は変わらず。何度か試行錯誤したが、一向に進展がなかった。

さらに気になったのは「gemini-1.0-pro」というモデル名を使っている点である。現時点でGeminiは一部関係者向けにのみテストが行われているとされており、一般ユーザーは使えない可能性がある。おそらく権限が付与されていない、あるいはまだ公開されていないモデルを呼び出しているためにエラーになっているのだろう。代わりに chat-bison-001 や text-bison-001 を呼んでみても、今度は別のパラメータやJSON構造の問題でつまずく始末だった。

結局、現段階では「GeminiをCursor上で動かす」という当初の目的は果たせなかった。試しにcurlで単純なリクエストを送ってみてもエラーが返る状況なので、もう少し情報が揃うまで待つしかなさそうである。

本来であれば、新しいLLMをいち早く触ってみたいところだが、サービスの公開時期やAPIの仕様が不透明だと、このように苦戦する羽目になる。エラーメッセージは少しヒントを与えてくれるものの、そもそもアクセス権限がなければ手も足も出ない。もしかしたら、正式公開される頃には大幅に仕様が変わっているかもしれないが、それまではやきもきしながら待つしかないというのが現状である。

以上、「Geminiを使おうとしたらうまくいかなかった」という話であった。